Sahte porno video üretmek kolaylaştı, sonuçları ciddi olacak

Son haftalarda internete yüklenen ve deepfake (derin sahte) denilen sahte pornolarda bir patlama yaşanıyor.

Son haftalarda internete yüklenen ve deepfake (derin sahte) denilen sahte pornolarda bir patlama yaşanıyor. Bu tür videolarda, yalnızca fotoğraflarına sahip olunan bir kişinin yüzü, bir porno videosundaki aktrisin yüzüne monte ediliyor.

Bu videoları üretmeyi sağlayan araçlar daha güçlü ve daha kolay kullanılır hale geldikçe, insanlar hayallerindeki cinsel fantezileri internete aktarma imkanı buluyor.

Fakat bu tür videolar ahlaki sınırları aşmanın yanısıra gördüklerimize inanma hissimizi de etkiliyor.

Uyarılma amaçlı bu sığ kullanımın yanısıra sahte video teknolojisi ciddi sonuçlara yol açabilir.

Şarkıcı Ariana Grande'nin fotoğraflarının yüklendiği yazılım, onun yüzünü bir porno videosundaki aktrisin yüzüyle değiştirmiş

Kurumlar ve şirketler bu gelişmeye hazırlıksız yakalandı.

'Deepfake' videoların yayınlandığı internet siteleri gelişmeleri yakından takip ettiklerini söyleseler de bu konuda ne yapabilecekleri hakkında bir fikirleri yok.

Bu tekniği kullanan topluluklarda ise ünlü yüzlerin hiç beklenmedik seks videolarında görünmesinin getirdiği bir heyecan var.

Bu topluluklarda yaptıkları şeyin gerçek etkileri tartışılırken vicdanın izine rastlamak çok zor. Başka birinin yüzünü kullanarak bir porno video yaratmak etik dışı mı? Öyleyse ne önemi var? Birine zarar veriliyor mu?

Ekran görüntüsü alınan bu videoda görüldüğü gibi Emma Watson'ın yüzü de 'deepfake' videolarda kullanılıyor

Belki de yaptıklarının, kullanılan kişiye ne hissettirdiğini düşünmeleri gerekir.

Reddit sitesinde bir kullanıcının söylediği gibi, bu distopik bilim kurgu dizisi Black Mirror'dan fırlamış bir uygulamaya benziyor.

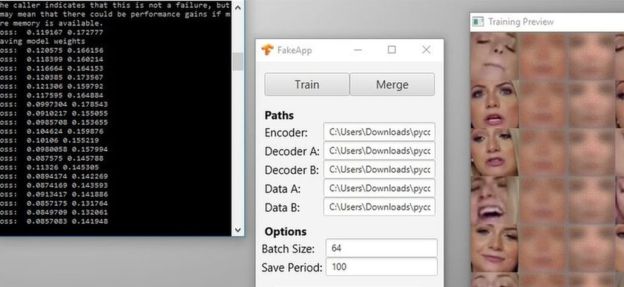

Nasıl yaratılıyorlar?

Bu tür videoları yaratmayı sağlayan ve bir ay önce yayınlanan yazılımlardan biri, programı yaratan kişiye göre bir ay içinde 100 binden fazla indirildi.

Natalie Dormer gibi Taht Oyunları aktrislerin de yüzleri bu tür videolarda kullanılıyor

Sahte pornografik görüntüler yüz yıldan uzun bir süredir yaratılmakta olsa da bu çok zorlu bir süreçti, özellikle de videolarda. Gerçekçi videoların Hollywood stüdyolarında kullanılan türden yazılımlara, yeteneğe ve büyük bir bütçeye ihtiyacı oluyordu.

Fakat makine öğrenimi sayesinde bu süreç üç basit adıma indirgendi: Bir kişinin çok fazla fotoğrafını edin, pornografik videoyu seç ve bekle. Kısa bir video için 40 saat gibi bir süre gerekse de bilgisayarlar gerisini hallediyor.

En popüler sahte pornolarda ünlüler yer alsa da yeterince fotoğrafı bulunan herkesin deepfake videosu yapılabilir. Ve günümüzde herkesin sosyal medyaya yüklediği selfie sayısını düşününce bu hiç de zor bir şey değil.

Wonder Woman aktrislerinden Gal Gadot'un yüzü de birden fazla 'deepfake' porno videoda kullanıldı

Bu teknik dünyanın dört bir yanında ilgi görüyor. Son dönemde Güney Kore'de 'deepfake' terimini kullanarak yapılan aramalarda bir patlama yaşandı.

Bunun arkasında muhtemelen 23 yaşındaki pop yıldızı Seolhyun'un bu şekilde üretilen videoları yatıyor.

Görüntüleri izleyenlerden biri, videoyu yapan kişiyi şu sözlerle övüyordu:

"Bu, 'deepfake'in yasadışı olması gerektiğini hissettiriyor. Müthiş bir çalışma!"

Ünlüler hedef alınıyor

'Deepfake' videoları hazırlayanlar özellikle ünlüleri hedef alıyor.

Bunun arkasında şok etkisi varmış gibi gözüküyor: Bu videolarda gerçekten ünlü aktrislerin yer alması bir skandala yol açardı.

Nicholas Cage ve Donald Trump'ın yüzlerinin kullanıldığı bir video

'Deepfake' videolar hazırlayan topluluklar arasında Emma Watson ve Natalie Portman en popüler iki ünlü.

Fakat onların dışında Michelle Obama, Ivanka Trump ve Kate Middleton gibi kadınlar da kullanılıyor.

Wonder Woman'ı oynayan Gal Gadot'un yüzünün kullanıldığı video ise bu teknolojinin imkanlarını gösteren ilk videolardan biri olmuştu.

Teknoloji sitesi Motherboard tarafından yayınlanan bir makalede bu teknolojinin bir yıl içinde yayılacak kadar gelişeceği öngörülmüştü.

Fakat o noktaya gelmesi yalnızca bir ay sürdü.

Bu videolar daha fazla öfkeye yol açarken bu videoların paylaşıldığı siteler önlem olarak deneysel adımlar atmaya başladı.

Fakeapp adlı Windows programı, yeterince fotoğrafına sahip olunan kişilerin yüzlerinin videolara yerleştirilmesini kolaylaştırıyor

Resim barındırma sitesi Gyfcat, 'deepfake' olarak tanımladığı görüntüleri sildi. Fakat yakın gelecekte bu çok daha zor bir görev haline gelecek.

'Deepfake' topluluğunun kullandığı Reddit sitesi ise henüz bir adım atmadı. Fakat BBC'nin edindiği bilgilere göre site yönetimi gelişmeleri yakından takip ediyor.

Belli bir görsel için Google'da yapılan aramalarda da bu sonuçlarla karşılaşılabiliniyor.

Halihazırda Donald Trump'ın suratını kullanarak yapılmış sahte videolar internette dolaşıyor. Bunların sahte olduğu bariz olsa da propaganda amaçlı üretilmesi durumunda yaratacağı etkiyi tahmin etmek kolay.

Videolardan birinde Austin Powers filmindeki Dr. Evil'ın yüzünü Donald Trump'ın yüzüyle değiştirmiş

Google geçmişte bazı materyallerin daha zor çıkması için arama sonuçlarında değişikliklere gitmişti. Fakat aynısını 'deepfake' için de yapıp yapmayacakları henüz netleşmiş değil.

Pek çoğumuz gibi şirketler de bu tür görüntülerin var olduğunu yeni yeni fark ediyor.

Son yıllarda bu siteler daha çok, insanları utandırmak için başkaları tarafından ve rızaları olmadan yayınlanan "intikam pornosu" içerikleriyle mücadele etmekle uğraşıyordu.

'Deepfake' videolar ise insanları utandırmak için yapılabileceklere yeni bir seviye ekliyor.

Bir video gerçek olmasa bile yol açacağı psikolojik hasarlar gerçek oluyor.

Siyasi istismar

Teknoloji haberciliğinde inovasyonun en büyük etmenlerinden birinin porno sektörü olduğu söylenir: Video sıkıştırma tekniklerinden video kasetlere kadar pek çok alanı etkilemiştir.

Pornoyla yayılmaya başlanan bu olgu da, hayatın diğer alanlarını da etkileyebilir.

Bu videoda da Hillary Clinton'ın kafasına Donald Trump'ın yüzü eklenmiş

The Outline için yazdığı bir makalede gazeteci Jon Christian, en kötü ihtimali değerlendiriyor ve bu teknolojinin "hükümetleri veya halkları kandırarak uluslararası bir çatışma yaratmak için kullanılabileceğini" söylüyor.

Bu, ihtimal dışı bir tehdit değil. Sahte haberler (ister dalga geçmek ister insanları kandırmak için yapılmış olsun) halihazırda küresel bir tartışmaya yol açmış, fikirleri değiştirmiş ve belki de seçimleri etkilemiş durumda.

Adobe gibi şirketlerin ses teknolojisindeki ilerlemeleriyle birlikte hem görüntünün hem de sesin yapay zekayla yaratıldığı ve en pürdikkat izleyiciyi bile kandırabilecek görüntülerin yayılması işten bile değil.

Fakat şimdilik, bu sadece pornoyla sınırlı.

Bu yazılımla video üretenler ise konunun etrafından dolanmıyor.

Bir Reddit kullanıcısı tartışmalarla ilgili "Burada yaptığımız şey gurur duyulacak ya da erdemli bir şey değil. Aksine aşağılayıcı, kaba ve fotoğrafları kullanılan kadınların hazırlıksız yakalanmasına yol açıyor" dese de 'deepfake' videoların intikam pornolarının etkisini azaltabileceği gibi gülünç bir uydurmanın arkasına sığınıyor:

"Eğer her şey gerçek olabilirse hiçbir şey gerçek değildir.

"Böylece intikam pornosu yayınlanan kişiler kolaylıkla bu videonun sahte olduğunu söyleyebilir."

Bu tür mazeret bulma uzmanları, videolarda görüntüleri yer alanların psikolojilerindense videoları yaratanların psikolojilerini korumaya çalışıyor.

Fakat 'deepfake' topluluğunun haklı olduğu bir nokta var: Bu teknoloji artık burada ve bu noktadan geri dönüş yok.

Dave Lee/BBC

HABERE YORUM KAT

Türkçe karakter kullanılmayan ve büyük harflerle yazılmış yorumlar onaylanmamaktadır.